解構生成式AI:從理論到部署,全面賦能新世代開發者

第一節:剖析AI革命 — 從理論到Transformer架構的演進

在投入建構複雜的AI應用之前,深入理解其背後的理論基礎至關重要。唯有掌握了核心原理,開發者才能跳脫單純的API調用,打造出真正穩健且具備創新性的解決方案。這門課程的起點,正是對生成式AI的本質進行系統性剖析。

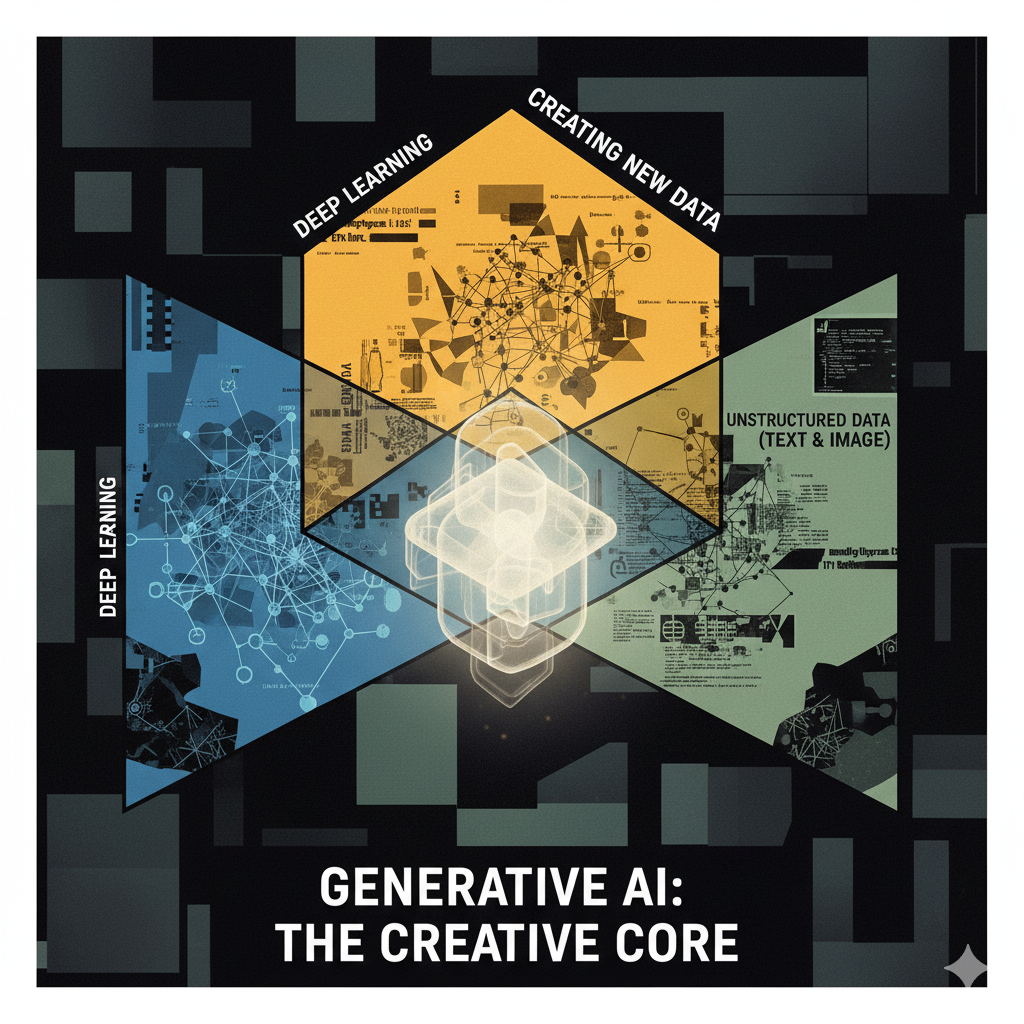

生成式AI被定義為深度學習(Deep Learning)的一個子集,其核心能力在於創造全新的、非結構化數據,例如文字與圖像。這與傳統的判別式模型(Discriminative Models)形成鮮明對比;後者專注於分類或預測(例如,判斷一首歌曲屬於搖滾還是古典樂),而生成式AI則專注於「生成」。

課程追溯了處理序列數據模型的技術演進,清晰地勾勒出一條從基礎到突破的發展路徑:

- 循環神經網路 (RNNs): 作為處理序列數據的早期模型,RNN因其在長序列中反覆傳遞資訊的機制,容易引發梯度消失或爆炸問題,導致難以學習長期依賴關係。

- 長短期記憶網路 (LSTMs) 與門控循環單元 (GRUs): 為了解決RNN的缺陷,LSTMs和GRUs應運而生,它們透過更複雜的內部「門」結構,顯著提升了模型處理長序列的能力。

- 編碼器-解碼器 (Encoder-Decoder) 架構: 這一架構的出現,專門解決了如機器翻譯這類輸入與輸出序列長度不一致的問題,是序列到序列任務的一大進步。

Transformer架構: 2018年發表的論文《Attention Is All You Need》帶來了革命性的突破。Transformer架構徹底摒棄了RNN的循序處理機制,完全依賴於注意力機制 (Attention Mechanism) 來捕捉序列中的依賴關係。其最大的優勢在於能夠並行處理輸入數據,這不僅大幅提升了訓練速度,更為訓練擁有數十億甚至數兆參數的現代大型語言模型(LLM)奠定了基礎。這種向並行處理的轉變不僅是漸進式的改進,它從根本上打破了序列模型的擴展性障礙,直接促成了定義現代AI景觀的、龐大參數規模的LLM的訓練。

正是Transformer這一里程碑式的架構,開啟了當前的大模型時代。接下來,我們將探討開發者如何利用OpenAI的強大模型與LangChain框架,將這些理論轉化為實際的應用程式。

第二節:現代LLM工具箱 — 駕馭OpenAI與LangChain框架

若說Transformer架構是現代AI的理論基石,那麼OpenAI的API與LangChain框架便是當代LLM應用開發者的核心工具箱。它們將複雜的底層模型封裝起來,讓開發者能專注於打造功能豐富且具備商業價值的應用。

OpenAI API 提供了一個無縫接軌的入口,讓開發者能夠直接調用經過海量數據預訓練的頂尖模型。課程中重點介紹了其核心功能,包括用於對話式應用的 Chat Completion API,並闡明了 tokens 作為計費與輸入長度限制的基本單位,是所有開發者必須掌握的基礎概念。

然而,單純的API調用僅能完成簡單任務。為了編排更複雜的工作流程,LangChain 框架應運而生。LangChain 的強大之處在於其基於組件、可組合的架構,它抽象化了樣板程式碼,讓開發者能像堆疊積木一樣,將從具備上下文的記憶體到能使用工具的代理人等精密功能串連起來。它如同一個智慧的協調器,將LLM與外部世界無縫連接,其核心組件包括:

• 提示詞模板 (Prompt Templates): 允許開發者創建動態且結構化的提示詞。透過預設的模板與變數,可以根據不同的用戶輸入生成精確的指令,引導LLM產出更符合預期的結果。

• 鏈 (Chains): 這是LangChain的核心概念,用於將多個LLM呼叫或其他組件串聯起來,形成一個連貫的執行流程。例如,可以先用一個LLM生成摘要,再將摘要傳遞給另一個LLM進行翻譯,實現複雜的多步驟任務。

• 代理 (Agents): 賦予了LLM「思考」與「行動」的能力。它允許LLM動態決定使用哪些外部工具(如Google搜索、計算機)來回答問題,從而突破了模型訓練數據截止日期的知識限制,使其能夠處理即時資訊。

• 記憶 (Memory): 為了讓應用程式具備上下文感知能力,記憶組件扮演了關鍵角色。它能儲存和管理對話歷史,使LLM在後續的互動中能夠「記住」先前的對話內容,打造出如同真人般流暢的對話體驗。

• 文件加載器 (Document Loaders): 此功能讓LLM能夠讀取和處理來自外部數據源的資訊,例如從PDF文件中提取文本,為後續的知識庫問答應用奠定基礎。

然而,依賴這個專有技術堆疊並非唯一途徑。一個充滿活力的開源生態系正在迅速成熟,為願意走出圍牆花園的開發者提供了強大、透明且具成本效益的替代方案。

第三節:衝破圍牆花園 — 開源模型的崛起與實踐

這種從專有API到易於獲取的開源替代方案的演進,標誌著一次關鍵的權力轉移,將以往僅限於大型科技公司的能力賦予了個人開發者和新創企業。以Meta的Llama 2、Falcon和Bloom為代表的開源大型語言模型,正成為商業閉源模型的有力替代品,它們不僅推動了技術創新,更促進了整個社群的透明度與可及性。

開源模型的主要優勢在於:

• 成本效益: 無需支付昂貴的API調用費用。

• 高度自由: 可自由用於學術研究甚至商業用途,不受特定供應商的限制。

• 數據隱私: 可在本地部署,確保敏感數據不離開自有伺服器。

然而,這些優勢也伴隨著挑戰,最主要的是需要自行託管模型,這對硬體資源(特別是GPU)提出了較高要求。為了解決此問題,一項關鍵技術應運而生:

模型量化 (Quantization)

模型量化 (Quantization) 是一項核心優化技術,旨在縮減大型模型的記憶體佔用。其原理是將模型權重從高精度的浮點數(如32位元)轉換為低精度的整數(如8位元或4位元)。雖然這會帶來微小的精度損失,但卻能大幅降低模型的大小,使得在消費級硬體甚至僅有CPU的環境中運行大型模型成為可能。本質上,量化讓AI模型更加民主化,極大地降低了硬體入門門檻,使在消費級設備上直接運行強大智能成為可行之事。

掌握了這些先進的理論與工具後,最終的目標是將它們整合起來,建構並部署能夠解決真實世界問題的完整應用。

第四節:從程式碼到雲端 — 建構並部署真實世界的AI應用

理論知識的真正價值,體現在解決實際問題的應用之中。課程的最終階段,便是引導開發者將所學融會貫通,從零開始建構並部署端到端的專案,完成從理論學習者到全棧AI開發者的蛻變。

課程的核心專案旨在應用所學的全部概念,例如打造一個基於特定文件的問答系統。這類專案是檢索增強生成 (Retrieval-Augmented Generation, RAG) 的典型應用。系統首先使用文件加載器讀取一份指定的PDF文件,接著將文本切分成小區塊,並利用嵌入模型將其轉換為向量。這些向量儲存在一個專門的向量資料庫 (Vector Database) 中。當用戶提問時,系統會先在向量資料庫中檢索最相關的文本區塊,再將這些區塊連同用戶的問題一起發送給LLM,從而生成精確且基於文檔內容的回答。

除了應用程式的建構,課程還涵蓋了部署這一關鍵環節。開發者將學習部署模型的核心MLOps概念,將整個應用交付為一個穩定運行的線上服務。這一過程提供了寶貴的全棧開發經驗,確保開發者不僅能編寫AI邏輯,更能將其產品化,這對於專業開發者而言至關重要。

結論

總結而言,以freeCodeCamp的課程為代表的全面性教育資源,正與一個由OpenAI等商業巨頭和Llama 2等開源社群共同構成的豐富工具生態系相結合。這種知識與工具的雙重賦能,正在全球範圍內催生新一代的AI開發者。他們不再僅僅是消費API,而是在架構智能系統,將GPT和Llama 2等模型的理論力量轉化為有形的、解決真實世界問題的方案,積極地塑造著我們的未來。

資料來源

• YouTube 影片: "Generative AI Full Course – Gemini Pro, OpenAI, Llama, Langchain, Pinecone, Vector Databases & More", freeCodeCamp.org 頻道。